category

AI summary

tags

password

summary

date

icon

status

字数统计

type

slug

orgsrc

URL

当开发者们准备在 Apple Vision Pro 尝试各种脑洞大开的创意应用时,他们也许会回想起「Privacy」一词被反复提及了 64 次的 WWDC 2023(仅 Spatial Computing 相关 Session):

很多人会觉得所谓的 Privacy-first design(用户隐私优先的设计)只是一种产品公关策略或者公司价值观的宣扬。但实际上,我们可以从几个实际案例来理解,visionOS 是如何在系统接口层面保护用户隐私数据的(哪怕很多人觉得是过度保护)。

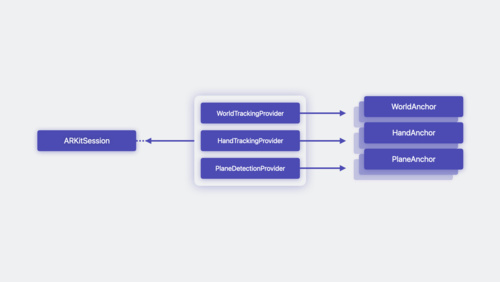

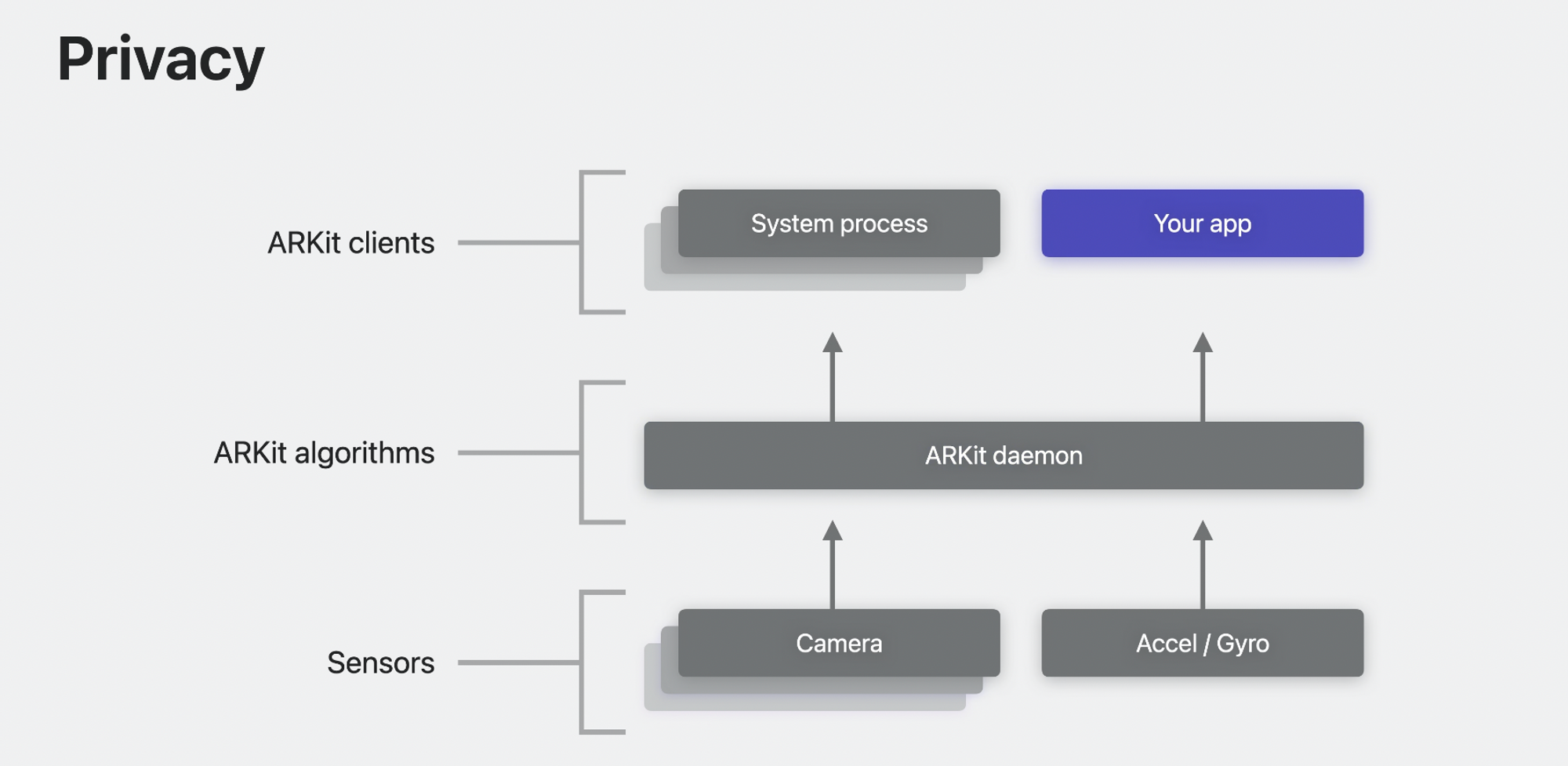

由于 ARKit 处理了几乎绝大部分用户环境信息,无论是 VST 相机的视频流还是各种加速传感器,都会经过 ARKit 底层算法的加工后,再将结果暴露给系统进程或三方应用,包括平面检测、环境位置追踪、手部追踪、场景理解、图像追踪等。下图是 ARKit 处理底层数据的流程,所有灰色部分代表由 visionOS 系统接管:

在此基础上,用户相关数据同样在三个层级上获得保护:

- 首先是原始视频流、传感器数据,由于涉及用户第一视角并且是 always-on 状态,任何三方应用都无法直接获取,更重要的是,用户自己也无权共享;

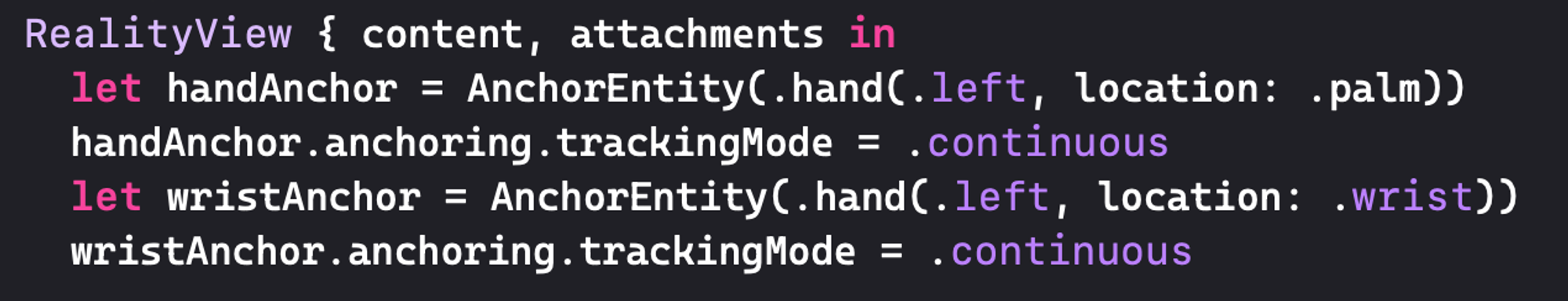

- ARKit 算法基于传感器数据可以输出环境、手等追踪数据,visionOS 可以在不暴露具体空间坐标数据的情况下,处理三方应用对空间信息的请求;例如下面这个手部追踪 UI 的示例,应用只需要通过

AnchorEntity接口绑定手部位置,而无法获取具体坐标:

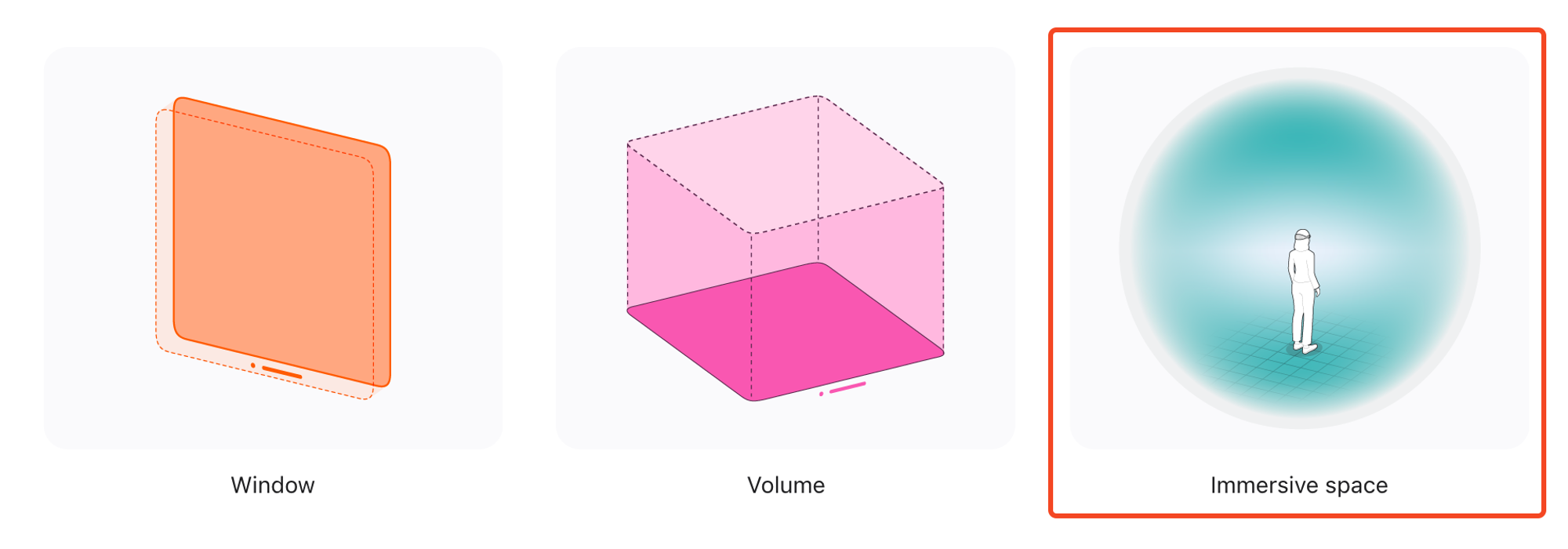

- 最后,三方应用可以从 ARKit 获取算法处理后的追踪数据数据,但前提是只能在 Immersive Space 模式,也就是说只能在 Apple Vision Pro 的“全屏”模式下,由当前应用独享用户数据;这种情况隐私数据就像在保存在黑洞中:

例如所有手势追踪、平面识别的应用,都只能在当前应用范围内获取、处理用户数据:

其实对于 VST 视频流或原始的传感器的隐私保护,大部分用户是可以理解的,毕竟涉及到自己周边环境的真实(图像)信息;但是对于经过 ARKit 计算处理后的场景坐标信息,很多人可能觉得有点过于严苛了,毕竟如果三方应用只是知道我的面前有一张桌子,但不知道桌子的图像信息,这似乎并没有泄露自己的什么隐私,同时又可以换取更好的体验(比如把 3D 手办固定在桌面上,同时不影响其它应用任务正常运行)。

如果要类比这一场景中的隐私数据和用户体验之间的权衡,iOS 中的第三方键盘就是一个很好的例子。键盘如果作为一个三方应用横跨所有应用场景,它可以不知道当前具体的输入应用,但却能够获取用户所有的输入信息。而在 visionOS 中,用户面前的桌子(空间信息),就是那个横跨所有应用的信息锚点。

直到 iOS 8,苹果才开放了第三方键盘的权限,而现在 visionOS 最新版本,才只到 Beta 1.2。

最后

技术的便利性和用户隐私之间的关系,永远是不断权衡和演进的。对待用户隐私的态度,则是一个产品或一家公司价值观的体现,而绝非技术能力的体现。相信很多人看到过下面这段国内某互联网企业老板对于用户隐私的态度:

中国人更加开放或者对隐私问题没有那么敏感,如果说用隐私来交换便捷性或者效率,很多情况下他们是愿意这么做的。

为了防止断章取义,他的后半段完整表述如下:

我们当然要遵循一系列的原则,如果我们认为用这个数据会让所有者受益,而且他也愿意让你去使用他的数据,我们会使用的,这是我们的一个基本的做法。

如果你也认同这一观点,或许可以重读一下《许三观卖血记》,当然,是站在许三观的视角而不是医院视角。

如果自由不加以限制,一定会导致强者对弱者的剥削。